OpenAI連續(xù)12天“王炸”的第二彈來了。不同于第一日聚焦人工智能(AI)模型,第二日的王炸專注于服務企業(yè)等組織的一款新功能,雖然看起來不太側重于普通消費者,但據(jù)介紹它甚至可以讓簡易版推理模型o1 mini的效果超過本周四發(fā)布的正式版o1、所謂滿血o1。

美東時間12月6日周五,OpenAI在社交媒體X公布第二日活動的主題是新功能“強化微調”(Reinforcement Fine-Tuning)。這個主題是指,企業(yè)組織將能夠通過“強化微調”微調o1 mini,滿足他們的特定需求。

OpenAI CEO Sam Altman在X發(fā)帖稱,強化微調的效果非常棒,是他今年最大的驚喜之一,期待看到大家利用這種功能的創(chuàng)造。

OpenAI的研究員本周五介紹,科學家、開發(fā)人員和研究人員可以根據(jù)自己的數(shù)據(jù)、而不是僅僅使用公開可用的數(shù)據(jù),量身定制OpenAI的強大推理模型o1。不同行業(yè)的人可以使用強化學習來創(chuàng)建基于 o1 的專家模型,從而提高該領域的整體專業(yè)知識水平。開發(fā)者、研究者和機器學習工程師將首次能運用強化學習,打造精通他們各自專業(yè)領域的專家模型。

OpenAI的研究員稱,強化微調并不是單單教模型模型輸出,它的運作方式是,當模型發(fā)現(xiàn)一個問題的時候,研究者給模型空間區(qū)仔細思考這個問題,然后評估模型給出的最終解答,運用強化學習,研究者可以強化產(chǎn)生正確答案的思路,抑制產(chǎn)生錯誤答案的思路,只需要“幾十個例子”(a few dozen examples)、甚至12個例子,模型就能以有效的新方式學習特定領域的推理。

通過強化學習,用戶可以用大模型在特定數(shù)據(jù)上訓練其他模型。這對于涉及到大量數(shù)據(jù)的復雜領域或需要專家領域知識的新研究非常有用。研究者舉例稱,最近和湯森路透合作,運用強化微調微調o1 mini,讓它充當法務助理,幫助他們的法律專業(yè)人士完成大部分分析工作流。

OpenAI稱,OpenAI的定制模型平臺將支持強化學習,強化學習也是OpenAI內部用于訓練自家前沿模型的技術,如GPT-4o和o1系列模型。在OpenAi的內測中,強化微調已經(jīng)在生物化學、安全、法律和醫(yī)療保健領域取得成功。OpenAI計劃,2025年初讓強化微調面向公眾發(fā)布,目前已對企業(yè)、大學和研究院開放申請測試通道。

伯克利大學罕見遺傳病研究員 Justin Reese參與了OpenAI本周五對o1 mini模型的現(xiàn)場演示。演示中,研究者試圖從樣本數(shù)據(jù)池中獲取可能導致疾病的模型 ID 基因。

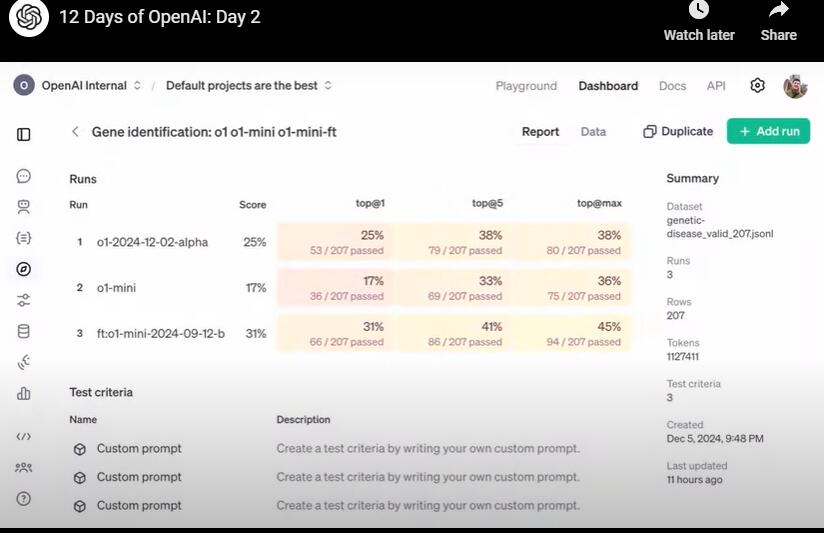

研究員展示了一個評估表,下圖可見,第一行是本周四OpenAI發(fā)布的正式版o1測評表現(xiàn),第二行是o1 mini的測評結果 ,第三行結果來自經(jīng)過最終強化微調的o1 mini。研究員進行了三類評估,其中,top @1是測試模型給出的正確答案出現(xiàn)在列表最前列中的概率,top@5是正確答案出現(xiàn)在前五列的概率,top@max是答案出現(xiàn)在所有正確答案列表的概率。

如圖所示,正式版o1的測試通過率為25%,o1 mini為17%,而強化微調后的o1 mini竟然達到31%,超過了正式版o1,比正式版o1的測評結果高24%,而且相比未強化微調前,微調后的結果提高了82.3%。